Los avances científico-tecnológicos que nos han llevado a que los pronósticos meteorológicos sean tan tan buenos a día de hoy

Hace 54 años, en enero de 1967, un bigote desapareció de la televisión por culpa de una mala predicción meteorológica. Eugenio Martín Rubio, entonces ‘hombre del tiempo’ de Televisión Española, se jugó ante la audiencia de la entonces única cadena del país que, si al día siguiente no llovía en Madrid, se afeitaría su mostacho. “Estoy tan seguro [de que va a llover] que de no ser así mañana me afeito el bigote”, dijo en antena. Al día siguiente, apareció en pantalla con su labio superior despoblado.

La anécdota de Martín Rubio es un chascarrillo y comentario habitual en la rama de la predicción meteorológica española. Pero seguramente si Rubio -fallecido en 2016 a los 92 años- hubiese contado con las condiciones técnicas con las que hoy se hacen los pronósticos, habría tenido muchas más posibilidades de mantener su bigote intacto.

“Hoy podemos emitir una predicción para el tiempo que va a haber en los próximos 5 días con las mismas probabilidades de acierto que tenían los pronósticos para 24 horas en los años 80”, explica Juan Jesús González Alemán, Doctor en Física e investigador en ciclones, dinámica atmosférica y cambio climático de la Universidad Complutense.

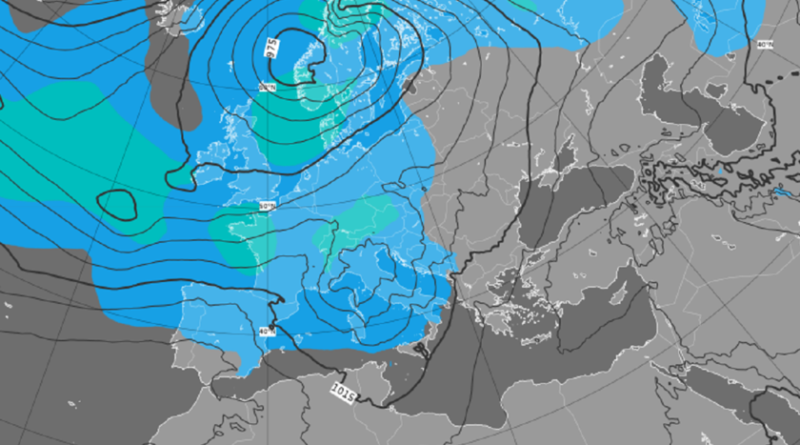

La ciencia de la predicción meteorológica ha avanzado en la última década y media de forma fulgurante gracias a dos caras de una misma moneda: las cada vez mayores fuentes para obtener datos y la capacidad de procesarlos. Dicho en lenguaje meteorológico: recopilación y asimilación. Una suerte de “revolución silenciosa” a nivel técnico y científico que ha dado pasos de gigante gracias a la mejora de los ordenadores que deben incorporar la ingente cantidad de indicadores que a día de hoy recopilan estaciones, sondas meteorológicas, boyas o satélites.

“Donde hace 15 años un ordenador necesitaba de 5 a 6 horas para procesar un modelo meteorológico solo para las próximas horas, ahora lo puede hacer, para el mismo nivel de detalle, en pocos minutos”, cuenta José Miguel Viñas, meteorólogo de Meteored, quien afirma que ahora mismo, “aunque siempre puede fallar”, se puede decir que una predicción tiene muchas posibilidades de acertar en un horizonte de 72 horas. “A partir de ahí, la línea se difumina y no deberíamos darle tanta confianza, aunque cada vez son más fiables también los modelos de entre 5 días y una semana”, explica.

Todos estos avances no solo han redundado en que los hombres y mujeres del tiempo puedan apostar ante la audiencia con más seguridad, sino también en el fin último de las predicciones: evitar grandes desastres por causas meteorológicos.

Evolución de la fiabilidad de las previsiones por pronósticos a distintos rangos temporales: de 3 días a 10. Extraído de ‘The quiet revolution of numerical weather prediction’, Nature (2015)

Evolución de la fiabilidad de las previsiones por pronósticos a distintos rangos temporales: de 3 días a 10. Extraído de ‘The quiet revolution of numerical weather prediction’, Nature (2015) Todos los meteorólogos consultados por Xataka para este reportaje coinciden en que durante el reciente episodio de la borrasca Filomena la predicción meteorológica acertó en gran medida gracias a la continua revisión de los modelos y las distintas probabilidades y el uso del Nowcasting, técnica que consiste en ir revisando la previsión a muy corto plazo -hablamos de apenas horas- gracias a la llegada de nuevos datos casi de forma continua.

“Se venía avisando de la posibilidad de nevadas bastante copiosas, y se acertó mayoritariamente. Otra cosa es que los avisos meteorológicos fueran traslados por las autoridades en forma de alertas y movilización de recursos”, se moja Emilio Rey, divulgador meteorológico y director de la app tuMeteo, una solución de pronóstico del tiempo hiperlocal centrada en la ciudad de Madrid y en la personalización de las previsiones.

Eso no evita que un parte meteorológico siga teniendo posibilidades de ser completamente erróneo cada vez que lo vemos en nuestro smartphone o en el espacio del tiempo en televisión. Pero en esa carrera por saber qué tiempo hará mañana se ha avanzado más por reducir esa incertidumbre en los últimos años que en toda la historia de esta ciencia.

Un océano de datos que debe ser procesado

Para Marta Ferri Llorens, meteoróloga en la Delegación de la Comunidad Valenciana de la AEMET, algo que ha cambiado con rotundidad desde que comenzó a trabajar en 2008 es la cantidad de antiguas ‘zonas oscuras’ que ahora sí que aportan datos a los modelos globales.

Los ordenadores de los modelos meteorológicos globales analizan dos veces al día una ingente cantidad de datos

“Hasta hace no mucho África y buena parte de los océanos eran puntos ciegos en los que no se podía extraer información porque no había estaciones o sistemas de medición adecuados. O, si lo había, no estaba conectado. Ahora, los satélites y las mejores conexiones gracias a internet han permitido que el volumen de datos sea mucho mayor”, cuenta.

Los meteorólogos comparan la llegada de internet a su ciencia con otro hecho también determinante siglo y medio atrás: la invención y el uso masivo del telégrafo, que a finales del siglo XIX consiguió que el envío de información meteorológica fuera mucho más fluido.

“Aun así”, dice Ferri, “si queremos predicciones meteorológicas cada vez más fiables seguiremos necesitando cada vez más y más datos, y por lo tanto más capacidad de computación para procesarlos”. Es, en cierto sentido, una carrera que nunca va a terminar, porque el objetivo final, simular el comportamiento futuro de la atmósfera, es perseguible pero no alcanzable.

“Jamás habrá una predicción meteorológica 100% segura”, apunta José Miguel Viñas, una frase que también se repite bastante al hablar de meteorología, y no por salvar a los ‘hombres y mujeres del tiempo’, sino porque es uno de los campos de la ciencia donde más fácilmente se aplica la Teoría del Caos.

De satélites a estaciones de aficionados pasando por aviones comerciales: todas las vías por las que se intenta ‘ver’ cómo está la atmósfera

Por eso es tan importante contar con la máxima cantidad de datos. La ciencia detrás de la creación de un pronóstico del tiempo comienza con millones de observaciones de factores como la velocidad del viento, la presión del aire, la humedad y la temperatura. Los datos globales de instrumentos terrestres y marinos se comparan con los de aeronaves, globos meteorológicos y satélites fuera de la atmósfera terrestre.

En esta captación de datos “un hecho diferencial ha sido la mejora de los satélites”, dice Viñas. Y no porque sea una tecnología nueva -en los 60 ya se lanzó el primer satélite meteorológico- sino por los avances de las últimas generaciones.

Imágenes en infrarrojos del Meteosat

Imágenes en infrarrojos del Meteosat En la actualidad los satélites de referencia para Europa son los archiconocidos Meteosat, capaces de interpretar la temperatura o las nubes a diversos niveles gracias a la radiación y el reflejo de la luz solar. Tras una primera generación que se lanzó de 1977 a 1997, hasta 2015 se fue desplegando la segunda. Los Meteosat 2 añaden a su capacidad el monitoreo detallado de la convección de masas de aire que pueden provocar tormentas violentas, la detección de niebla, y un mejor seguimiento de las masas de aire. A partir de 2021, además, se espera que comience el despliegue de una tercera generación de Meteosat, aún con mayor resolución.

“La mejora satelital se ha notado tanto en la resolución como en la entrada de datos. Ahora los satélites nos envían barridos cada 15 minutos, cuando con la generación anterior era cada media hora y con menos detalle”, relata Ferri, en cuya Delegación en la AEMET en Valencia vigilan el tráfico aeronáutico para toda España. “Puede parecer un cambio no muy sustancial, pero en situaciones de riesgo o inestabilidad estamos hablando de doblar la velocidad con la que recibimos datos”.

Estos datos de satélite se suman a las estaciones, sondas y también a los que mandan los colaboradores que en el caso de España tiene la AEMET. “Unas 3.000 personas en todo el país, aficionados a la meteorología, que mandan sus datos porque tienen una pequeña o a veces gran estación en su casa”, dice Ferri, quien pone en valor la contribución de estas personas, “ya que cuantos más datos tengamos, la previsión tiene más posibilidades de ser fiable”.

Sin embargo, en los últimos años, los satélites a 35.000 kilómetros por encima de nuestras cabezas, y las estaciones a pie de tierra, han sumado un nuevo aliado en su captación de datos: los aviones y, en concreto, los comerciales.

“Los aviones suelen volar a una altura -entre 10 y 12 kilómetros- que es especialmente pertinente a la hora de captar datos sobre masas de aire, humedad y fenómenos atmosféricos”, explica Emilio Rey, quien también se dedica a divulgar estos conceptos en su podcast.

Al hilo de esto, desde hace poco más de un lustro la Organización Meteorológica Mundial ha comenzado a desarrollar el programa AMDAR (Aircraft Meteorological Data Relay), para que aerolíneas comerciales lleven en sus vuelos sistemas de monitoreo de temperaturas y viento en altura.

“No está funcionando tan bien como se esperaba porque muchas aerolíneas no se han unido, pero la asimilación de datos de estos vuelos es tremendamente valiosa, por lo que podría ser un punto más de mejora en el futuro”, afirma González Alemán.

En el siguiente mapa se puede ver la cantidad de vuelos diarios que se introducen en el modelo europeo ECMWF. Una situación que durante el confinamiento, por el cese de los vuelos, dio que pensar sobre si las previsiones iban a ser tan exactas.

Una vez que se tienen todos estos datos de tan distintas fuentes, se introducen en un modelo numérico de predicción meteorológica. Simplificando mucho, unas ecuaciones complejas que tienen en cuenta la dinámica de fluidos y las posibles alteraciones para, con estos datos iniciales, intentar predecir cómo evolucionarán en el tiempo.

“Las ecuaciones no han variado de sus fundamentos [las ecuaciones de Navier-Stoke], pero sí que se han ido perfeccionando y mejorando varios aspectos en torno a la dinámica de tormentas, las perturbaciones… Los modelos meteorológicos nunca han dejado de mejorarse”, explica Juan Jesús González.

“Se necesitarían 64.000 personas para procesar estos datos a tiempo”. Superordenadores al rescate

Eso sí, desde los inicios de los sistemas de predicción numérica, se tuvo claro que aquellas ecuaciones jamás podrían ser resueltas por un humano, al menos en un tiempo adecuado. En 1910 el matemático inglés Lewis Fry Richardson intentó predecir el tiempo que habría dentro de seis horas con estas ecuaciones. El problema: tardó seis semanas en resolverlas, y además no con resultados satisfactorios. Entonces se dice que dijo que “harían falta 64.000 personas trabajando por turnos para prever el estado de la atmósfera con mayor rapidez que la de su evolución real”.

Además de los satélites, por los vuelos comerciales pasan muchas de las mejoras a futuro

Aquellas 64.000 personas fueron solventadas gracias a la llegada de los primeros ordenadores. El ENIAC, considerada una de las primeras computadores prácticas, hizo correr la primera previsión para las próximas 24 horas en los años 50… después de que tres meteorólogos lo estuvieran programando durante 33 días.

“Desde entonces, la capacidad de la meteorología ha avanzado de la mano de las mejoras en la capacidad de procesamiento de los superordenadores, hasta el punto de que los principales centros meteorológicos cuentan con algunas de la máquinas más potentes del mundo”, cuenta José Miguel Viñas.

Existen dos modelos meteorológicos a escala global dominantes, y todos se cimentan sobre grandes centros computacionales: el modelo americano GFS de la NOAA, y el del Centro Europeo de Predicción a Medio Plazo (ECMWF), con sede en Reading, Inglaterra y que es el que tiene importancia también para la AEMET en España.

“Siempre ha habido cierto pique pero hoy el más completo se puede decir que es el Europeo”, cuenta Viñas. Este particular pique dio un empujón al modelo de Reading cuando en 2012 había predicho correctamente la brusca entrada del huracán Sandy contra la costa este de Estados Unidos dos días antes que los pronosticadores estadounidenses.

¿Pero qué tipo de información devuelven estos modelos y sus macroordenadores? Para hacerse una idea, el modelo europeo, tras asimilar las decenas de miles de registros que le llegan, hace correr el modelo -es decir, las ecuaciones- dos veces al día con 50 pasadas en cada ocasión para encontrar posibles perturbaciones.

Los resultados que devuelven son traslados para su visualización a un sistema que divide la superficie de la Tierra en rejillas de 16 kilómetros inicialmente, que pueden llegar a ser ampliadas hasta 2,5 kilómetros de ancho. “Imaginemos dividir la Tierra en parcelas de 16 kilómetros, y en cada parcela ejecutar los cálculos con sus condicionantes para intentar predecir qué tiempo va a hacer. Pues eso es lo que hacen estos ordenadores y los meteorólogos todos los días”, señala Rey.

Ese modelo global es después tomado por las agencias locales de cada territorio, en el caso de España la AEMET, que los vuelve a trabajar ahora añadiendo nuevas capas de datos, con modelos como el Hirlam o el Harmonie, que acercan aún más las previsiones a espacios más concretos y son pasados 4 veces al día.

“Con estas distintas pasadas vamos obteniendo cada vez ‘fotos’ más cercanas. Del área de una ciudad a un barrio, y así sucesivamente”, explica Ferri, que en este momento reivindica la labor del predictor. “Por mucho que se acerquen estos modelos, la labor del predictor, la persona que hace los pronósticos, siempre va a ser importante. Porque aunque la resolución por ejemplo nos acerque a un pueblo muy pequeño, es posible que no sepa interpretar la existencia de una montaña que vaya a modificar el sentido de las precipitaciones. Todo debe ser revisado”.

Los superordenadores de la AEMET funcionan con Linux (Red Hat) y 31,5 TB de RAM

Hacer un recorrido por los ordenadores que ha tenido la AEMET a lo largo de su historia reciente puede ser un buen indicador de cómo se ha progresado.

El primer ordenador que tuvieron en la Agencia, cuando se llamaba Instituto Nacional de Meteorología, fue un IBM 370 que estuvo operativo hasta 1983 y por supuesto funcionaba con tarjetas perforadas. En aquella década se pasó a un Fujitsu FACOM-M382, y que ya era capaz en en hora y media de correr un modelo de 100 kilómetros de rejilla (ahora hablamos de hasta 2,5 kilómetros). Después se pasó a dos superordenadores CRAY, hasta llegar al actual, instalado en 2014 y ampliado dos años más tarde: un ordenador Bull DLC B710, el cual consta de 324 nodos instalados en 18 chasis (18 nodos por chasis) y 2 procesadores por cada nodo.

El Superordenador BULL DLC B700 de la AEMET

El Superordenador BULL DLC B700 de la AEMETLos procesadores son Intel Xeon 2697 V2 Ivy Bridge a 2.7 Ghz, con 12 cores por cada procesador (lo que supone que este sistema dispone de 7.776 cores, informan desde la AEMET). En cuanto a RAM, 144 nodos disponen de 64 GB de RAM y 180 nodos disponen de 128 GFB, de memoria DDR3, por lo que la capacidad total de memoria del ordenador es de 31,5 TB.

Funciona con el sistema operativo Linux Red Hat y el sistema de almacenamiento ligado a este ordenador está formado por cabinas NetApp, con 462 TB brutos de capacidad. Como resumen: ofrece una potencia final de hasta 168 Teraflops, unas 75 veces más potente que el superordenador Cray al que sustituyó.

No culpes al hombre o la mujer del tiempo. Es la teoría del caos, amigo

Con toda esta base ya armada, nuestros meteorólogos consultados coinciden al señalar por donde pueden ir las mejoras a futuro.

“Siguiendo esta senda y con la mejora en la capacidad de procesamiento, es posible que en unas décadas la fiabilidad de los pronósticos a una semana sean tan buenos como los que ahora tenemos a tres días”, piensa Viñal.

La predicción a pequeña escala, la entrada de la IA y los pronósticos probabilísticos marcarán un futuro que se prevé soleado para la meteorología

“El futuro puede estar en la mejora de la resolución que nos permita ofrecer resultados cada vez más cercanos, más locales y más certeros; y aunque pueda parecer contradictorio también en la mejora de modelos estacionales, más a largo plazo, que también están mejorando mucho”, cuenta por su parte Marta Ferri.

Los otros dos grandes avances son en gran medida usos que ya están aquí, pero que faltan por comunicar. Desde hace años la predicción por conjuntos, que apuesta por introducir pequeñas perturbaciones en los datos iniciales para intentar simular parte del caos de la atmósfera y su impredecibilidad, ha abierto nuevas perspectivas. “Digamos que en las ecuaciones iniciales distorsionamos los datos para intentar crear un conjunto que simule las perturbaciones que se pueden crear en cualquier momento en la atmósfera, y que hacen que por muy buena que sea, una predicción pueda ser errónea”, explica González Alemán.

Unos avances que de un modo u otro pasarán también por el perfeccionamiento del Big-Data y la Inteligencia Artificial. Microsoft ya está trabajando en redes de IA capaces de resolver ecuaciones a corto plazo para prevenir grandes desastres. Por ahora el veredicto es que consiguen resolverlas de forma mucho más ágil, pero con mayor nivel de error que los modelos tradicionales.

Lidiar con el peso de la Teoría del Caos que en la meteorología muestra su cara más evidente –cualquier oscilación en la entrada de una masa de aire, cualquier variación en la humedad por mínima que sea, puede cambiar el pronóstico por completo- se ha convertido también en un reto a la hora de comunicar.

“Estamos acostumbrados a pronósticos deterministas, que nos digan ‘el miércoles llueve en Madrid’, pero lo cierto es que el camino está yendo más hacia los pronósticos probabilísticos”, nos dice Emilio Rey, quien ejemplifica: “son resultados que veríamos como que hay un 60% de posibilidades de que caiga 1,5 litros, un 20% de que caigan 3, un 5% de que no llueva… Esto es algo con lo que ya se trabaja en el día a día a nivel interno, pero el reto es comunicarlo también a todo el mundo”, concluye.

Imagen | Michael Newton | Flikkersteph | EUMETSAT

–

La noticia

Los avances científico-tecnológicos que nos han llevado a que los pronósticos meteorológicos sean tan tan buenos a día de hoy

fue publicada originalmente en

Xataka

por

Víctor Millán

.